Appel à communication

Les méthodes d’analyse statistiques de textes (lexicométrie, textométrie, linguistique computationnelle, text mining, etc.) connaissent aujourd’hui d’importants développements dans tous les champs scientifiques et dans la société en général. Ces méthodes peuvent en effet répondre aux questions et aux intérêts d’acteurs multiples (entreprises privées, acteurs de la gestion publique, des milieux du renseignement, data-journalism, etc.). Elles prennent également une place croissante dans les sciences humaines et sociales, et notamment chez les chercheurs et chercheuses qui se réclament des humanités numériques. Ceci a donné lieu à de nombreux colloques, à des rencontres scientifiques régulières, telles que les JADT, et à plusieurs synthèses récentes (Léon & Loiseau 2016, Jenset & McGillivray 2017).

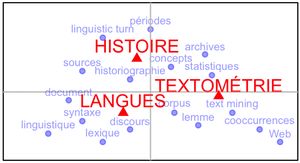

La position des historien·nes peut paraître paradoxale : leur travail repose en grande partie sur des textes utilisés comme sources, et les évolutions de l’historiographie moderne les ont conduits à accorder une attention toujours plus grande aux discours et aux représentations des acteurs du passé. La lexicométrie historique a à ce titre connu de grands succès et bénéficié d’une excellente visibilité dès les années 1970, notamment au Centre de lexicologie politique de l’ENS Fontenay/Saint-Cloud. Pourtant, malgré l’influence du linguistic turn et le développement d’outils informatiques à la fois plus puissants et plus accessibles, les usages de la textométrie en histoire se sont révélés plus dispersés par la suite, malgré d’incontestables succès (Genet 2011). La faible présence des historien·nes aux JADT est de ce point de vue symptomatique.

On entrevoit aujourd’hui un renouveau de l’approche textométrique en histoire, mais suivant une démarche différente, celle du text mining, pensée comme une aide au dépouillement d’archives textuelles massives issues de programmes de numérisation des sources (Projet Corpus de la BnF par exemple – Moiraghi 2018).

L’objectif de ce colloque est de dresser un panorama des utilisations actuelles des méthodes d’analyse statistique des textes en histoire, quelle que soit la période et l’espace étudiés, à un moment où le contexte intellectuel, social et technique invite ainsi à les repenser. Plusieurs questions peuvent être posées pour mieux comprendre leur place et leurs apports en histoire.

Axe 1 : L’historiographie du rapport entre langue et histoire

Depuis les débuts des relations entre histoire, linguistique et statistique lexicale, les historiens n’ont jamais cessé de réfléchir sur leurs pratiques (Robin 1973 ; Guilhaumou, Maldidier, Robin 1994 ; Genet 2011 ; Léon 2015 ; Léon & Loiseau 2016), et de nombreuses questions historiographiques restent ouvertes. S’interroger sur les relations entre la discipline historique, la langue et le discours implique ainsi de revenir sur les étapes fructueuses de cette histoire comme les travaux du laboratoire de lexicologie politique de l’ENS Fontenay/Saint-Cloud, ou ceux du laboratoire de statistiques linguistiques de l’Université de Nice. Mais aussi de réfléchir aux entreprises scientifiques et intellectuelles qui, bien qu’elles eurent une grande importance épistémologique, n’ont pas toujours été poursuivies avec la même intensité, telles que les recherches de Michel Pêcheux et de Denise Maldidier. De même, il reste à interroger les modalités des relations entre histoire, linguistique et textométrie, à l’image par exemple des parcours d’historiens comme Jacques Guilhaumou ou Régine Robin, qui se caractérisent par le passage d’un recours à la statistique lexicale à des démarches plus proches de l’histoire conceptuelle.

Axe 2 : Les renouvellements méthodologiques liés aux corpus

Sous-axe 2.1 : Vers des sources et objets linguistiques renouvelés pour la textométrie ?

En France, la lexicométrie historique s’est originellement attachée à l’étude de la littérature politique et syndicale. Si cette tradition demeure vivace (Mayaffre 2010) et touche parfois le grand public (Alduy 2017 ; Souchard, Wanich & Cuminal 1998), on peut se demander quels sont les autres types de sources soumis aujourd’hui par les historien·nes à cette approche. Certaines « langues » présentent de forts particularismes – celles des chartes, des câbles diplomatiques, ou encore du droit par exemple. D’autres sources se caractérisent par des conditions d’énonciation particulières (oralité, écrits de l’intime et du for privé, textes littéraires...). Quels sont alors les problématiques et les protocoles d’analyses les plus pertinents ?

La langue peut elle-même devenir objet d’histoire, en particulier lorsqu’elle fonctionne comme le vecteur d’un pouvoir. C’est par exemple ce qu’a montré Serge Lusignan en histoire sociolinguistique (Lusignan 2004 et 2012), dans une perspective plus qualitative. Les enjeux langagiers de la domination sont également au cœur d’approches historiographiques comme l’histoire du genre ou les postcolonial studies. On peut alors s’interroger sur la place des méthodes textométriques dans ces démarches et sur leur capacité à saisir les stratégies discursives et les faits de discours qui sont au cœur de leur analyse.

De nombreux champs de la discipline historique ont parallèlement été renouvélés par le « tournant documentaire » (archival turn – voir par exemple Chastang 2008 pour l’histoire médiévale ou Guyotjeannin 1995), consistant à considérer la source, l’archive, comme un objet construit dont l’étude des conditions de production et de conservation complète ou enrichit l’interprétation du contenu. Dans cette perspective, la lexicométrie perd-elle de son utilité ou peut-elle être réinvestie d’autres missions centrées sur le document lui-même, sur ses aspects formels, sa genèse ou son devenir ?

Sous-axe 2.2 : Les données textuelles à l’ère du big data et leurs relations aux historiens

L’outillage statistique de la lexicométrie suppose de disposer d’un corpus de textes non seulement représentatif mais aussi relativement important pour produire des résultats significatifs. Au-delà des débats sur la taille idéale d’un corpus lexicométrique en histoire, on peut se demander comment varier les échelles d’analyse en articulant des méthodes complémentaires (fouille de textes sur de gros corpus vs. analyse ciblée d’un lexique). La question prend d’autant plus d’importance que se multiplient les sources numérisées ou nativement numériques, tels que les écrits du Web. Comment les historiens peuvent-ils s’approprier ces gisements de données textuelles, et que peuvent-ils apporter, forts de leur expérience critique des sources, sur leur constitution et leur utilisation ? L’actualité des publications montre que ces transformations touchent toutes les périodes historiques et des objets variés, (Mayaffre 2010, Perreaux 2014, par exemple) et bouleversent la géographie de la recherche (Putnam 2016). Nous voudrions lors de ce colloque poursuivre et approfondir ce questionnement.

Axe 3 : Les développements de l’outillage statistique

Sous-axe 3.1 : La temporalité

Éviter l’anachronisme dans le sens des mots lorsque l’on étudie un corpus de manière diachronique est un souci ancien pour les historiens (Prost 1988). Les recherches dans ce domaine semblent aujourd’hui reprendre un intérêt nouveau notamment en ce qui concerne la visualisation de la temporalité (Ratinaud & Marchand 2014). Si on laisse parler les mots, la lexicométrie peut aider à dégager un temps lexical, des cycles utiles au travail de l’historien (Salem 1988). Il existe des méthodes statistiques (AFC, topic modeling...) permettant de percevoir des phénomènes de substitutions lexicales, mais les transformations sémantiques sont encore assez peu abordées en histoire. Existe t-il des moyens pour percevoir des évolutions sémantiques ? Peut-on retracer des influences sémantiques dans le temps ? Comment faire avec des données temporelles discontinues, parfois très espacées dans le temps ? Ces questions relèvent naturellement de la démarche de l’historien, qui travaille par définition sur la temporalité, mais elles prennent une importance particulière dans le domaine des écritures numériques qui, bien souvent, sont structurées de manière chronologique (Facebook, Twitter, etc.)

Sous-axe 3.2 : De nouveaux algorithmes pour la textométrie

Depuis l’ouvrage de Lebart et Salem (Lebart & Salem 1994), les outils statistiques se sont à la fois stabilisés et développés, et avec eux les protocoles d’analyse mis en œuvre dans les différents logiciels offerts en accès libre (autour de R par exemple, voir Bécue Bertaut 2018) ou via des plateformes Web. Les nouvelles méthodes que l’on voit naître permettent d’investir autrement des corpus, comme c’est le cas pour Linkage (http://linkage.fr) qui se propose d’introduire le texte dans les méthodes de classifications de réseaux sociaux. On pourrait également citer l’utilisation des topic models ou le développement récent d’algorithmes de deep learning reposant sur une approche par vecteur de mots (Embedding Layer, Word2Vec, GloVe). Les travaux utilisant ces méthodes (par exemple Levy & Goldberg 2014 ainsi que Barron et alii 2018) laissent entrevoir de forts potentiels pour la description rapide des contenus des documents et leur comparaison. Comment les historiens peuvent-ils se les approprier ?

Sous-axe 3.3 : Approches informatiques plus qualitatives

L’outillage informatique utile à une démarche linguistique dans les sciences humaines et sociales n’est pas que statistique, comme en témoigne par exemple le logiciel Nooj, qui permet une formalisation fine des langues naturelles. Une telle approche présente un intérêt pour la connaissance de l’état d’une langue, mais elle permet aussi de l’aborder dans sa diachronie.

Plus largement, se pose la question des approches qualitatives qui doivent trouver toute leur place dans ce colloque. L’enjeu est bien de profiter de la richesse et de la complémentarité des approches qualitative et quantitative de la langue (Paveau 2012), et ainsi d’aborder le plus largement possible les rapports entre langue et histoire. Les contributions illustrant le bénéfice de l’utilisation de ces différentes méthodes seront les bienvenues.

Bibliographie

- Alduy C., Ce qu’ils disent vraiment : les politiques pris au mot, Paris, Éditions du Seuil, 2017.

- Barron A. T. J., Huang J., Spang R. L., DeDeo S., « Individuals, Institutions, and Innovation in the Debates of the French Revolution », Proceedings of the National Academy of Sciences, 2018.

- Bécue Bertaut M., Analyse textuelle avec R, Rennes, Presses universitaires de Rennes, 2018.

- Chastang P., « L’archéologie du texte médiéval. Autour de travaux récents sur l’écrit au Moyen Âge », Annales. Histoire, Sciences sociales, 2008, vol. 63, n° 2, pp. 245-269.

- Genet J.-P., « Langue et histoire : des rapports nouveaux », in Bertrand J.-M., Boilley P, Genet J.-P. et Schmitt-Pantel P. (dirs.), Langue et histoire. Actes du colloque de l’école doctorale d’histoire de Paris 1. INHA, 20 et 21 octobre 2006, Paris, Publications de la Sorbonne, 2011.

- Guilhaumou J., Maldidier D. et Robin R., Discours et archive : expérimentations en analyse du discours, Liege, Mardaga, 1994.

- Guyotjeannin O., « L’érudition transfigurée », in Boutier J., Julia D. (dir.), Passés recomposés. Champs et chantiers de l’Histoire, Paris, Autrement, 1995, pp. 152-162. (coll. « Mutations »).

- Jenset G. B. et McGillivray B. (dirs.), Quantitative Historical Linguistics: A Corpus Framework, Oxford, New York, Oxford University Press, 2017.

- Lebart L. et Salem A., Statistique textuelle, Paris, Dunod, 1994.

- Léon J., Histoire de l’automatisation des sciences du langage, Lyon, ENS Éditions, 2015.

- Léon J. et Loiseau S. (dirs.), « Studies in Quantitative Linguistics » n°24, History of Quantitative Linguistics in France, Lüdenscheid, RAM-Verlag, 2016. (Studies of Quantitative Linguistics, n° 24).

- Levy O. et Goldberg Y., « Dependency-Based Word Embeddings », Proceedings of the 52nd Annual Meeting of the Association for Computational Linguistics (Short Papers), Association for Computational Linguistics, 2014, p. 302-308.

- Lusignan S., La langue des rois du Moyen âge : le français en France et en Angleterre, Paris, PUF, 2004.

- Lusignan S., Essai d’histoire sociolinguistique : le français picard au Moyen Âge, Paris, Classique Garnier, 2012.

- Mayaffre D., Vers une herméneutique matérielle numérique. Corpus textuels, Logométrie et Langage politique, Habilitation à diriger des recherches, Université Nice Sophia Antipolis, 2010.

- Moiraghi E., Le projet Corpus et ses publics potentiels. Une étude prospective sur les besoins et les attentes des futurs usagers, janvier 2018.

- Paveau M.-A., « L’alternative quantitatif/qualitatif à l’épreuve des univers discursifs numériques », conférence plénière au colloque Complémentarité des approches quantitatives et qualitatives dans l’analyse des discours ?, Amiens, Université de Picardie, CURAPP, 10‐11 mai (présentation : http://penseedudiscours.hypotheses.org/9711)

- Perreaux N., L'écriture du monde. Dynamique, perception, catégorisation du mundus au Moyen-âge (VIIème - XIIIème siècles). Recherches à partir de bases de données numérisées, thèse de doctorat, Université de Bourgogne, 2014.

- Prost A., « Les mots », in René Rémond (dir.), Pour une histoire politique, Paris, Éditions du Seuil, 1988, pp. 255‑258.

- Ratinaud P. et Marchand P., « Des mondes lexicaux aux représentations sociales. Une première approche des thématiques dans les débats à l’Assemblée nationale (1998-2014) », Mots. Les langages du politique, 2015, vol. 2, no 108, pp. 57‑77.

- Robin R., Histoire et linguistique, Paris, Armand Colin, 1973.

- Salem A., « Approches du temps lexical », Mots, 1988, vol. 17, no 1, pp. 105‑143.

- Souchard M., Wanich S. et Cuminal I., Le Pen, les mots : analyse d’un discours d’extrême-droite, Paris, La Découverte, Le Monde Édition, 1998.